Khoa Sư phạm

Trường Đại học Hà Tĩnh

Những cải tiến đột phá về hiệu suất phần cứng và phần mềm có thể chống lại sự gia tăng dự kiến về nhu cầu điện cần thiết để cung cấp năng lượng cho các mô hình ngôn ngữ lớn mới.

Khi ChatGPT của OpenAI được giới thiệu vào tháng 11 năm 2022, nó đã nhanh chóng thu hút sự chú ý của công chúng, trong vòng hai tháng hoạt động đã thu hút hơn 100 triệu người dùng. Kể từ đó, các nhà phân tích đã đưa ra những dự đoán đáng kinh ngạc về sự phát triển của trí tuệ nhân tạo tổng hợp (AI). Bloomberg Intelligence hồi tháng 3 dự báo thị trường trị giá 1,3 nghìn tỷ USD vào năm 2032, từ quy mô thị trường 40 tỷ USD vào năm 2022—tốc độ tăng trưởng kép hàng năm là 43%.

Có thông tin rộng rãi cho rằng các mô hình AI mới đang tiêu thụ nhiều năng lượng và chúng sẽ làm tăng thêm mức tiêu thụ điện của các trung tâm dữ liệu. Nhưng chưa có sự đồng nhất về quy mô của bước nhảy vọt đó.

Theo trung tâm dữ liệu Schneider Electric trình bày năm 2023, “Sự bùng nổ AI: Những thách thức và định hướng xây dựng Trung Tâm Dữ Liệu”, ước tính rằng lượng điện năng AI tiêu thụ chiếm 8% trong tổng số 54 GW của năm 2023. Schneider dự đoán tỷ lệ đó sẽ tăng lên 15–20% vào năm 2028, khi nhu cầu trung tâm dữ liệu được dự báo sẽ đạt trên 90 GW. Trong tổng mức sử dụng AI, 20% hiện được sử dụng để đào tạo các mô hình, phần còn lại sẽ dùng để suy luận - các trường hợp riêng lẻ mà mô hình được giao nhiệm vụ. Tỷ lệ này dự kiến sẽ tăng lên 15:85 vào năm 2028.

Kể từ khi giới thiệu ChatGPT và các mô hình ngôn ngữ lớn (LLM) khác, chẳng hạn như Copilot của Microsoft và Bard của Google, một số nghiên cứu của các cá nhân và các cơ quan báo chí đã dự đoán về nhu cầu tăng vọt về điện năng. Theo Alex de Vries, nhà phân tích dữ liệu, là nghiên cứu sinh tại Trường Kinh doanh và Kinh tế thuộc Đại học tự do của trường Amsterdam: nhu cầu điện toàn cầu dành cho AI có thể tăng lớn hơn toàn bộ mức tiêu thụ của Argentina vào năm 2027. “Với AI, nguyên tắc cơ bản là cái gì lớn hơn thì tốt hơn,” de Vries nói. “Các mô hình lớn hơn thì mạnh mẽ hơn và hoạt động tốt hơn. Nhưng chúng yêu cầu nhiều tài nguyên tính toán và tiêu thụ nhiều năng lượng hơn.”.

Dự đoán quá mức?

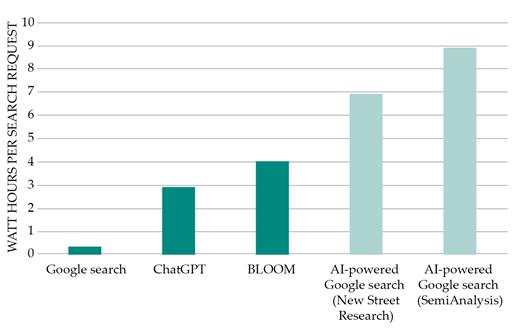

Trong một bài bình luận trên tạp chí Joule năm 2023, de Vries đã nhắc đến các ước tính của Chủ tịch Alphabet, John Hennessy, cho rằng: chi phí tìm kiếm trên Google có thể tăng gấp 10 lần nếu một mô hình ngôn ngữ lớn (LLM) được sử dụng cho mỗi tương tác (Xem Hình 1). Ông thừa nhận rằng điều này khó xảy ra trong thời gian gần. Điều đó sẽ đòi hỏi việc cung cấp hơn 500.000 máy chủ cao cấp, với chi phí lên tới khoảng 500 tỷ USD cho Google.

Tuy nhiên, các dự đoán trước đây về sự gia tăng theo cấp số nhân trong tiêu thụ năng lượng điện đã chứng minh là hoàn toàn không chính xác, theo Daniel Castro, người đã viết một báo cáo chi tiết vào tháng 1 về việc sử dụng năng lượng của AI cho Quỹ Công nghệ Thông tin và Đổi mới (ITIF) ở Washington, DC. Năm 2022, Trung tâm Chính sách AI và Kỹ thuật số đã tuyên bố rằng “các hệ thống hỗ trợ AI cần sức mạnh tính toán tăng trưởng theo cấp số nhân … mặc dù có nhiều bằng chứng cho thấy tuyên bố này là gây hiểu lầm và phóng đại,” theo báo cáo của ITIF.

Các cải tiến đáng kể về hiệu quả trong hoạt động của các trung tâm dữ liệu đã xảy ra khi số lượng các trung tâm này tăng lên. Một nghiên cứu nổi bật năm 2020 của Eric Masanet và các cộng sự cho biết, từ năm 2010 đến 2018, số lượng phiên xử lý tại các trung tâm dữ liệu đã tăng gấp hơn năm lần và dung lượng lưu trữ tăng gấp 25 lần, trong khi tổng lượng năng lượng tiêu thụ chỉ tăng 6%.

Hình 1. Kết quả phân tích của hai cách phân tích khác nhau: các tìm kiếm của Google sẽ cần lượng điện năng gấp 10 lần nếu chức năng trí tuệ nhân tạo được thêm vào.

Nhưng de Vries và những người khác lập luận rằng AI sẽ phát triển nhanh đến mức nó sẽ lấn át mọi sự gia tăng hiệu suất có thể đạt được từ phần cứng máy tính, điều mà họ cho rằng đã đạt đến giới hạn của định luật Moore đối với kích thước tính năng của chip. Roberto Verdecchia, trợ lý giáo sư tại Đại học Florence ở Ý, cho biết: “Người ta sợ bỏ lỡ cơ hội, dẫn đến cuộc đua để tạo ra một mô hình tốt hơn, mô hình mới có thể xuất hiện mỗi ngày, do đó không có thời gian để cải thiện hiệu suất sử dụng năng lượng.”

Nhận định của các nhà phát triển

Báo cáo năm 2023 của Google và Boston Consulting Group chỉ ra rằng thiết kế mô hình AI là một lĩnh vực đang phát triển, và các phiên bản mới liên tục xuất hiện với hiệu quả năng lượng được cải thiện trong khi vẫn duy trì hiệu suất. Báo cáo cho biết, những cải tiến trong phần mềm và tối ưu hóa thuật toán có thể nâng cao đáng kể hiệu suất và giảm yêu cầu tính toán. Ví dụ, 18 tháng sau khi phát hành GPT-3, mô hình AI được ChatGPT sử dụng, Google đã phát triển một mô hình ngôn ngữ lớn (LLM) gần gấp bảy lần so với GPT-3. Mô hình GLaM, vượt trội hơn GPT-3 và chỉ cần một phần ba năng lượng để huấn luyện, theo báo cáo của ITIF.

Một phát ngôn viên của OpenAI cho biết, công ty nhận thấy rằng việc huấn luyện các mô hình lớn có thể tiêu tốn nhiều năng lượng và họ luôn làm việc để cải thiện hiệu suất. Công ty “dành sự chú ý đáng kể về cách sử dụng sức mạnh tính toán của chúng một cách tốt nhất và hỗ trợ các nỗ lực của các đối tác để đạt được mục tiêu bền vững của họ.”

Các phiên huấn luyện mô hình của OpenAI, riêng lẻ rất tiêu tốn năng lượng, nên thường cho phép khách hàng bỏ qua việc huấn luyện các mô hình của riêng họ từ đầu, phát ngôn viên cho biết. “Chúng tôi cũng tin rằng các mô hình ngôn ngữ lớn có thể hữu ích trong việc thúc đẩy hợp tác khoa học và khám phá các giải pháp khí hậu.”

Microsoft, công ty đã giới thiệu chatbot LLM Copilot (trước đây là Bing Chat) vào năm 2023, đang đầu tư vào nghiên cứu và phát triển để đo lường tốt hơn việc sử dụng năng lượng và cường độ carbon của AI và tìm cách làm cho các mô hình lớn hiệu quả hơn trong việc huấn luyện và sử dụng, theo một phát ngôn viên.

Có những giới hạn thực tế về kích thước và các cải tiến có thể thực hiện đối với các mô hình ngôn ngữ lớn (LLMs) - do đó, có giới hạn về mức tiêu thụ năng lượng của chúng. Neil Thompson, giám đốc dự án nghiên cứu FutureTech tại Phòng thí nghiệm Khoa học Máy tính và Trí tuệ Nhân tạo của MIT, cho biết việc giảm một nửa lỗi do các LLM tạo ra cần gấp 1,9 triệu lần lượng tính toán hiện tại.

Jonathan Koomey, một thành viên của nhóm nghiên cứu được Quốc hội ủy quyền báo cáo về việc sử dụng điện trong các trung tâm dữ liệu cho biết: sự quan tâm và đầu tư gia tăng vào AI gợi nhớ đến những khoảng thời gian cường điệu về CNTT trước đây, như cơn sốt dot-com và việc xây dựng quá mức các mạng sợi quang trong những năm 1990. “Có những ứng dụng thực sự sẽ phát sinh từ AI, nhưng tôi rất hoài nghi rằng điều này sẽ trở thành một yếu tố chi phối toàn bộ nền kinh tế.” Ông cho biết không chắc rằng AI sẽ cải thiện độ chính xác của các tìm kiếm trên Google. “Nếu bạn có thể tự động hóa việc kiểm tra độ chính xác, thật tuyệt. Nhưng thế giới thì hỗn loạn và đầy những kẻ xấu cố gây rối, và có những vùng xám và mơ hồ. Bạn có thể sẽ không bao giờ giải quyết được vấn đề độ chính xác.”

Castro của ITIF dự đoán “sẽ có rất nhiều chỗ mà người ta thất bại khi cố gắng sử dụng AI, cũng có thể họ làm điều đó vì tính mới mẻ mà không có giá trị thực sự.” Ông cho biết các nhà phát triển đang tìm kiếm cách tạo ra các mô hình nhỏ hơn mà vẫn hiệu quả. Việc lưu trữ câu trả lời cho các yêu cầu thường xuyên thay vì tạo ra các phản hồi hoàn toàn mới cho mỗi trường hợp là một ví dụ.

Theo: Physics Today 77 (4), 28–29 (2024); https://doi.org/10.1063/pt.gqbw.iirw

Tin mới

- Sự kết hợp giữa công nghệ sinh học và AI - 10/10/2024 15:21

- Đoàn viên công đoàn khoa Sư phạm tích cực hưởng ứng các hoạt động chào mừng ngày Phụ nữ Việt Nam 20/10 - 07/10/2024 15:40

- Khai mạc Giải bóng đá nữ sinh viên Khoa Sư phạm năm 2024 - 06/10/2024 23:04

- Khoa Sư phạm tổ chức Hội nghị viên chức, người lao động năm học 2024 - 2025 - 01/10/2024 15:42

- Cán bộ, giảng viên, sinh viên Khoa Sư phạm quyên góp ủng hộ đồng bào khắc phục hậu quả bão lũ - 15/09/2024 14:52

Các tin khác

- Chào đón Tân sinh viên - 10/09/2024 15:32

- Rộn ràng không khí nhập học khoa Sư Phạm - 06/09/2024 09:21

- Những lưu ý dành cho tân sinh viên K17, ngành Giáo dục tiểu học! - 03/09/2024 00:30

- Vài nét về ngày 19/8 - 19/08/2024 02:37

- Kỷ niệm Ngày Cách mạng Tháng Tám năm 1945 – dấu ấn vinh quang trong lịch sử Việt Nam - 16/08/2024 09:59